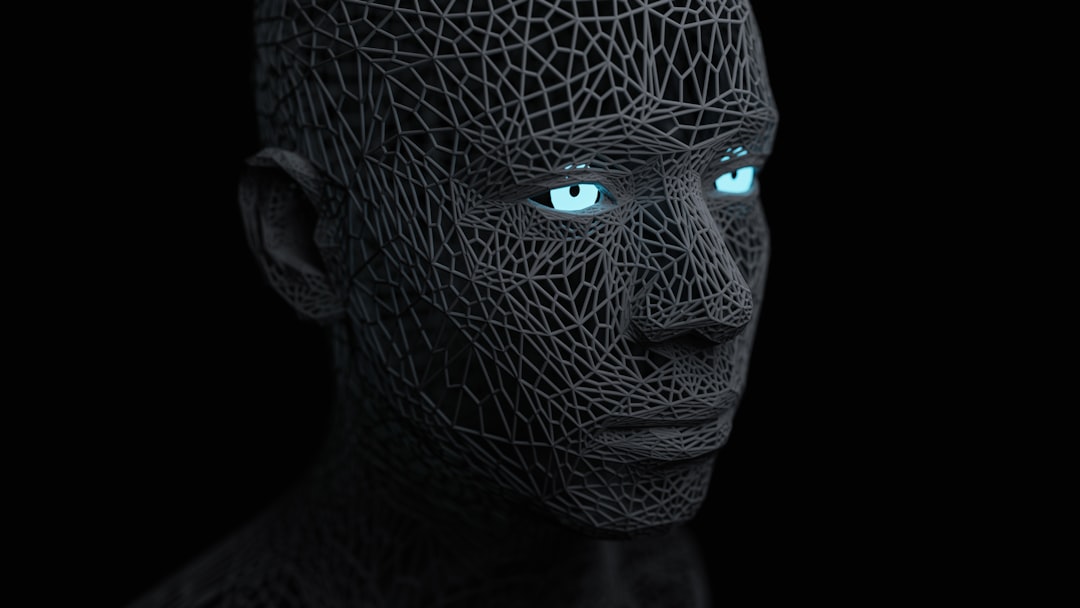

ה-FBI ביקש עזרה, והאינטרנט הפך את החקירה לסיוט: כך בינה מלאכותית כמעט ושיבשה הכל

התמונה המטושטשת שהציתה כאוס דיגיטלי

כאשר ה-FBI פרסם שתי תמונות מטושטשות של אדם המוגדר כ"בעל עניין" בחקירת ירי הקשור לפעיל הימין צ'רלי קירק, הסוכנות קיוותה בוודאי לקבל סיוע מהציבור. מה שהיא קיבלה במקום זאת היה הדגמה חיה ומטרידה לסכנות הטמונות בשימוש חובבני בבינה מלאכותית.

ברגע שהתמונות עלו לרשת החברתית X (לשעבר טוויטר), קהילה שלמה של "בלשי אינטרנט" נלהבים נכנסה לפעולה. חמושים בכלים כמו Grok של אילון מאסק, ChatGPT-4o, ומחוללי תמונות אחרים, הם החלו להריץ את התמונות המפוקסלות דרך אלגוריתמים במטרה אחת: "לשדרג" אותן ולקבל דיוקן חד וברור של החשוד. התוצאה הייתה לא פחות מקטסטרופלית.

כשהבינה המלאכותית "ממציאה" פנים

הבעיה המרכזית, שרבים מהמשתמשים התעלמו ממנה, היא שבינה מלאכותית אינה מבצעת שחזור אמיתי של מידע חסר. במקום "לנקות" את התמונה, המודלים הללו מבצעים "הזיה" (Hallucination) – הם למעשה ממציאים פרטים על סמך מאגרי המידע העצומים שעליהם אומנו. התוצאה אינה שיפור של המקור, אלא ניחוש משכיל במקרה הטוב, ויצירת פנים חדשות לחלוטין במקרה הרע.

הפיד ב-X הוצף במהירות בשלל גרסאות של החשוד, שלכל אחת מהן תווי פנים שונים. באחת התמונות שהופקו, החשוד קיבל סנטר מוגזם ולא מציאותי שכונה ברשת "סנטר ג'יגאצ'ד". בגרסה אחרת, צבע החולצה שלו השתנה לחלוטין. במקום לסייע, מבול המידע השגוי והסותר הזה רק יצר בלבול וסיבך את עבודת החוקרים, שנאלצו כעת להתמודד עם שלל "חשודים" מדומיינים.

לא רק טעות, אלא סכנה של ממש

התקרית הזו אינה מקרה בודד, אלא חלק ממגמה מדאיגה. בעבר כבר ראינו כיצד ניתן להשתמש לרעה בטכנולוגיית AI כדי לייצר מידע כוזב. דוגמאות מפורסמות כוללות מקרים בהם AI "הסיר פיקסלים" מתמונתו של הנשיא לשעבר ברק אובמה כדי להציג אותו כאדם לבן, או הוסיף פרטים בדויים לתמונותיו של דונלד טראמפ.

השימוש בכלים רבי עוצמה אלה על ידי הציבור הרחב בחקירות פליליות הוא מתכון לאסון. הוא עלול להוביל להפניית אצבע מאשימה כלפי חפים מפשע, לבזבז משאבי חקירה יקרים, ובסופו של דבר, לאפשר לפושעים האמיתיים לחמוק מעונש. הרצון הטוב לסייע מובן, אך במקרה הזה, הוא מוכיח כי הדרך לחקירה שירדה מהפסים רצופה בכוונות טובות ובפיקסלים שהומצאו על ידי מכונה.